不断变化和演进的 5G、数据中心、汽车和工业等应用,要求在保持严苛的电源包络的同时,持续提升计算能力。随着人工智能( AI )技术商用进程持续加速,其成为提升计算密度的一个主要因素。

无论是部署在云端、边缘还是终端,人工智能推断都需要更高的处理性能和严格的功耗预算,因而,人工智能推断工作负载,通常都需要专用的人工智能硬件来进行加速。

与此同时,人工智能算法的发展速度,远远超过了传统芯片开发周期的速度。由于先进的人工智能模型的快速创新,固定芯片解决方案,如人工智能网络的 ASIC 实现,有可能很快就会被淘汰。

自适应计算是应对上述挑战的答案

因为基于在产品制造之后依然可以针对特定应用而进行优化的自适应硬件而打造,自适应计算因而拥有独特的价值。由于优化可以在硬件制造完成之后按需进行,因此它可以保持与最新的人工智能模型与时俱进金。相反,ASIC 因为基于固定的硬件架构,一旦制造完成就无法改变。

自适应计算的这种灵活的优化能力,可以支持无限次地反复执行。甚至在器件被完全部署到量产环境后,依然可以进行硬件的变更。就像一个量产型 CPU 可以被用来运行一个新程序一样,一个自适应平台也可以灵活适应新的硬件配置,甚至可以在一个实时的生产环境中。

自适应硬件与其它替代方案的对比

CPU 和 GPU 各自具有其独特的能力,非常适合某些任务。CPU 是需要评估复杂逻辑的决策功能的最佳选择。GPU 是处理高吞吐量但对时延要求不高的离线数据的最佳选择。而自适应计算, 则是那些同时需要高吞吐量和低时延数据处理的最佳选择,如实时视频流、5G 通信和汽车传感器融合等应用。

自适应计算之所以能够在保证低时延的情况下提供高性能,是因为它能够实现领域专用的架构( DSA ),从而保障特定应用在特定领域架构上的最佳实现。相反,CPU 和 GPU 基于固定的、冯-诺依曼的架构,不允许对其底层架构进行针对特定领域的优化。

DSA 也可以使用专用(固定)芯片器件来构建,通常被称为特定应用标准产品或ASSP 。但是,在固定 ASSP 中实现 DSA,既有 有优势,也有劣势。这里介绍两种主要的劣势。

首先是创新步伐。为了跟上创新步伐,制造商被期望用更短的时间打造和提供新的服务。更具体来讲,这个时间要比设计开发新的固定芯片 DSA 所需的时间还要短。这就造成了市场的创新需求与企业设计制造 ASSP 所需时间之间的根本性市场错位。行业标准改变或其他需求波动,会很快导致这些器件过时。

第二个考量因素是定制芯片的成本。设计与制造独特的芯片设计(如复杂的 7nm ASIC)的一次性成本,可能导致数亿美元的非重复性工程( NRE )成本。随着器件工艺缩小到 5nm 及更小,预计成本还将进一步上升。成本的攀升,正在延缓 ASSP 对先进节点的采用,而这,可能导致其用户固守过时低效的技术。

自适应计算平台介绍

自适应平台都是基于相同的自适应硬件( FPGA )而打造,然而,它们所涵括的组件和 技术远远超过了芯片硬件和器件本身。自适应平台包含了一套全面的运行时软件,软硬件相结合为打造高度灵活和高效的应用,提供了一种独特的能力。

自适应平台使得自适应计算能够为广泛的软件和系统开发者所使用,并为其打造众多创新产品奠定了基础。采用自适应平台的优势包括:

● 缩短上市时间。使用 Alveo™ 数据中心加速器卡这样的平台,可以支持其无需定制硬件,就可以通过专门为特定应用加速而打造的硬件构建应用。而且,仅需将 PCIe 卡连接到服务器,就可以用现有软件应用程序直接调用加速库。

● 降低运营成本。与基于 CPU 的解决方案相比,由于计算密度的提升,基于自适应平台的优化应用能大幅提供每节点的效率。

● 灵活和动态变化的工作负载。自适应平台可根据当前需求重新配置。开发者可以在自适应平台内轻松切换已部署应用,使用相同设备即可满足不断变化的工作负载需求。

● 兼容未来。自适应平台能不断进行调整。如果现有应用需要新的功能,则可以对硬件重新编程,以最佳方式实现这些功能,减少硬件升级需求,进而延长系统使用寿命。

● 加速整体应用。AI 推断很少单独存在。它是更大的数据分析与处理链条的一部分,往往与使用传统(非 AI )实现方案的多个上游级和下游级并存。这些系统中的嵌入式 AI部分得益于 AI 加速,而非 AI 部分也能从加速中获益。自适应计算的天然灵活性适合为 AI 和非 AI 处理任务进行加速,这被称为“整体应用加速”。随着计算密集型 AI 推断渗透到更多应用中,“整体应用加速”的重要性也在日益提升。

● 易用性。过去,运用 FPGA 技术需要开发者构建自己的硬件板,并用硬件描述语言( HDL )配置 FPGA。相比之下,自适应平台则支持开发者使用自己熟悉的软件框架和语言(例如 C++、Python、TensorFlow 等),直接发挥自适应计算的效能。软件和 AI 开发者现在也可以直接使用自适应计算,而无需构建电路板或成为硬件专家。

不同类型的自适应计算平台

根据应用和需求,存在多种类型的自适应平台,包括数据中心加速器卡和标准化边缘模块。多种平台的存在,旨在为开发所需应用提供尽可能最佳的起点。不同的自适应平台所面向的应用类型也十分广泛,既有自动驾驶和实时视频流等时延敏感型应用,也有高度复杂的 5G 信号处理和非结构化数据库的数据处理。

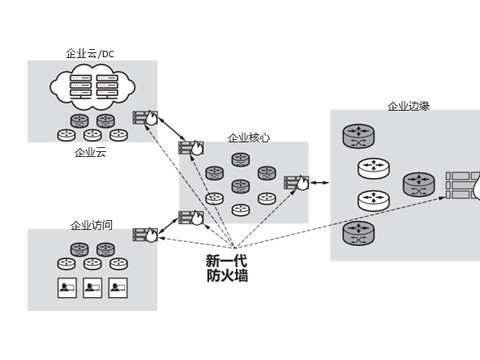

自适应计算能够部署到云端、网络、边缘甚至终端,将最新的架构创新带到单独及端到端的应用。鉴于存在各种自适应平台,部署位置也可以是多样化的——从数据中心内 PCIe 加速器卡上的大容量器件,到适用于物联网设备所需终端处理的小型低功耗器件。

边缘端的自适应平台,包括赛灵思 Kria™ 自适应系统模块( SOM ),数据中心中的自适应平台包括 Alveo 加速器卡。Alveo 加速器卡采用行业标准的 PCIe,为任意数据中心应用提供了硬件卸载能力。

Kria 自适应 SOM

AI 引擎的引入

自适应计算领域最大的创新之一,就是是赛灵思推出的 AI 引擎。

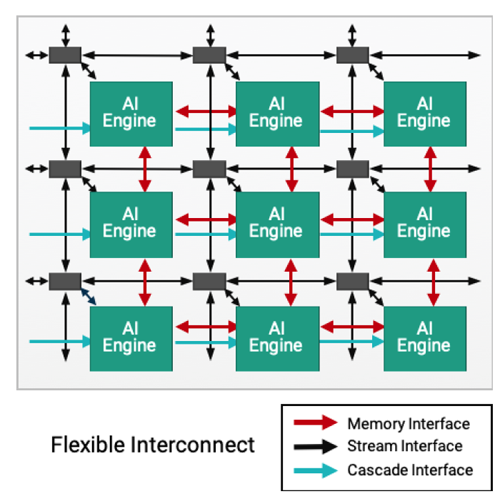

AI 引擎是一种革命性的新方法,其为计算密集型应用提供了前所未有的计算密度。AI 引擎从根本上说仍然是一个可配置的块,但它也可以像 CPU 一样进行编程。AI 引擎不是由标准的 FPGA 处理硬件组成的,而是包含高性能的标量和单指令多数据( SIMD )矢量处理器。这些处理器经过优化,用以高效实现人工智能推断和无线通信中出现的各种计算密集型功能。

人工智能引擎阵列,仍然与类似于 FPGA 的、灵活应变的数据互连相关接,从而能够为目标应用建立高效、优化的数据路径。这种计算密集型的、类似 CPU 的处理元素与类似 FPGA 的互连组合,正引领人工智能和通信产品迈入一个新时代。

赛灵思 AI 引擎架构

迎接一个更加互联和智能的世界

从根本上说,自适应计算建立在现有的 FPGA 技术上,但使其比以往任何时候都更容易被更多的开发者和应用所接受。软件和人工智能开发者现在可以借助这种对他们来说曾经遥不可及的用自适应计算硬件技术,快速打造优化的应用。

使硬件适应特定应用的能力,是自适应计算区别于 CPU、GPU 和 ASSP 的独特所在,后者的核心是固定的硬件架构。自适应计算允许硬件为应用量身定做,从而实现更高效率,而且如果未来工作负载或标准发生变化,其还能够根据需求进行调整。

随着世界变得更加互联和智能,自适应计算将继续占据优化、加速应用的前沿,助力各种各样的开发者加速将创意变成现实,让我们的明天更美好。

(作者:Greg Martin,赛灵思战略市场营销总监)

(采编:www.znzbw.cn)